7 wichtige Prompt-Patterns im Prompt Engineering

Keine Artikel mehr verpassen? Jetzt Newsletter abonnieren »

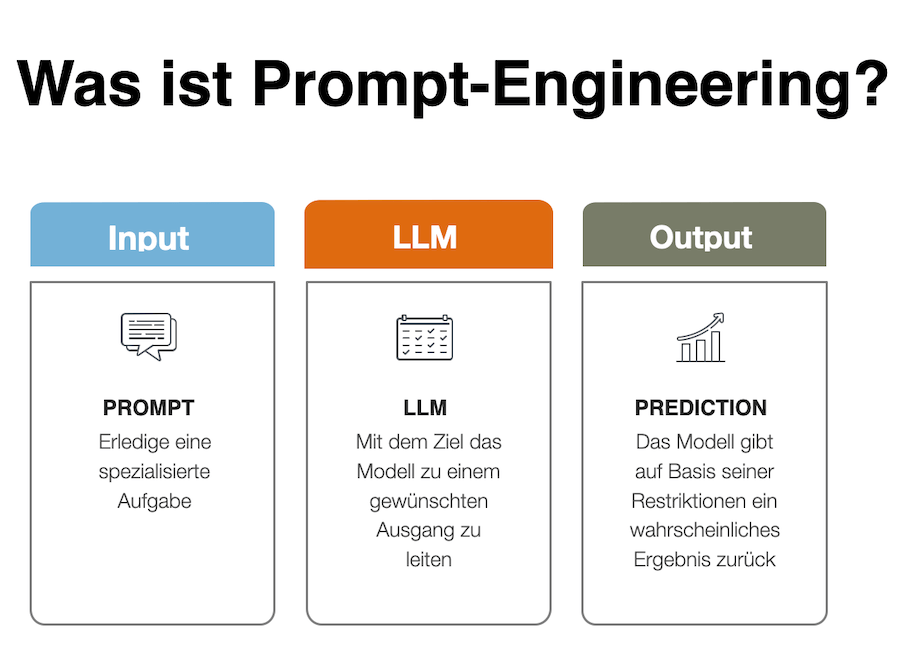

Prompts sind eine Art Programmierung und die effektivste Technik, um Abfragen an große Sprachmodelle (Large Language Models) zu stellen. Das Ziel ist ganz simpel – einen relevanten Output zu bekommen. Prompt-Engineering ist wiederum eine Sammlung einzelner Methoden, mit denen man diese LLMs (wie GPT-5.1) befragt. Zu diesen Methoden gehören unter anderem eine Rolle oder Kontext zu vergeben, Few-shot-Prompting oder auch komplexere Prompting-Techniken wie Chain-of-thought oder ReAct. Mittlerweilse existieren verschiedene Paper (Paper von Februar 2025, Paper vom Februar 2023), in denen sich eine Reihe von Autoren damit beschäftigt, wie Standard Muster für Abfragen aussehen könnten, sogenannte Prompt-Patterns. In diesem Artikel möchte ich dir einige dieser Prompt-Patterns für ChatGPT & Co. vorstellen

- Definition: Was sind Prompt-Patterns?

- Warum: Warum sind Prompt-Patterns interessant?

- Kategorien: Welche Kategorien von Prompt-Patterns gibt es?

- Pattern 1: Das Question Refinement Pattern

- Pattern 2: Das Persona Pattern

- Pattern 3: Das Audience Persona Pattern

- Pattern 4: Das Recipe Pattern

- Pattern 5: Das Template Pattern

- Pattern 6: Das Flipped-Interaction Pattern

- Pattern 7: Das Fact Check List Pattern

- Ressourcen: Weitere Ressourcen und Links zu Prompt-Patterns

Was ist ein Prompt-Pattern?

Definition: Ein Prompt-Pattern sind bestimmte Instruktionen, die dabei helfen, die gewünschten Antworten von LLMs zu bekommen. Dazu gibt es einen Katalog von Prompt-Engineering-Techniken, die in Form von Mustern beschrieben werden. Diese Muster können dann auf die verschiedenen Anwendungsfälle transferiert werden. Das Ziel ist es, durch Kreativität und Testen Modelle, beispielsweise GPT, optimal zu befragen und die Qualität der Outputs zu optimieren.

Warum sind Prompt-Patterns interessant?

Die Idee ist, ähnlich wie in der Software-Programmierung, wiederverwertbare Bibliotheken oder Templates zu generieren. Ein Prompt-Pattern bietet damit eine wiederverwendbare Lösung für ein wiederkehrendes Problem in einem bestimmten Kontext. Die Vorteile dieser Prompt-Patterns sind:

- Tailoring: Genau wie du eine E-Mail-Kampagne für eine spezielle Zielgruppe erstellst, musst du auch die Prompts genau anpassen, um mit LLMs die für dich besten Ergebnisse zu bekommen.

- Patterns: Die Prompt-Patterns helfen wiederkehrende Probleme mit „Templates“ zu lösen.

- Combine: Die besten Ergebnisse erzielst du, wenn du verschiedene Prompt-Patterns kombinierst.

Welche Kategorien von Prompt-Patterns gibt es?

Die Autoren des wissenschaftlichen Artikels haben 6 verschiedene Kategorien von Prompt-Patterns festgemacht. Ich möchte mich gleich auf die interessantesten Muster aus diesem Katalog konzentrieren. Aber im Überblick sind das die 6 Kategorien:

- Input-Semantics: Hier geht es darum, wie der LLM Eingaben versteht und verarbeitet. Zum Beispiel das Erstellen einer speziellen Sprache, damit der LLM bestimmte Ideen besser versteht.

- Output-Customization: Diese Kategorie hilft dir, die Art, das Format und die Struktur der Ausgaben des LLMs anzupassen. Hierzu gehören Prompt-Patterns wie die Automatisierung von Outpus, die Erstellung von Visualisierungen oder die Verwendung von Templates und Strukturen.

- Error-Identification: Hier werden Fehler in den Ausgaben des LLMs identifiziert und korrigiert. Zum Beispiel kann der LLM eine Liste von Fakten erstellen, die überprüft werden sollten.

- Prompt-Improvement: Diese Muster helfen, die Qualität der Eingabe und Ausgabe zu verbessern. Zum Beispiel kann der LLM Vorschläge für bessere Fragen machen oder alternative Ansätze für eine Aufgabe vorschlagen.

- Interaction: Hier geht es um die Interaktion zwischen dir und dem LLM. Der LLM kann beispielsweise Fragen stellen, statt Antworten zu geben oder in Form eines Spiels antworten.

- Context-Control: Dies ermöglicht dir, den Kontext der LLM-Outputs zu steuern.

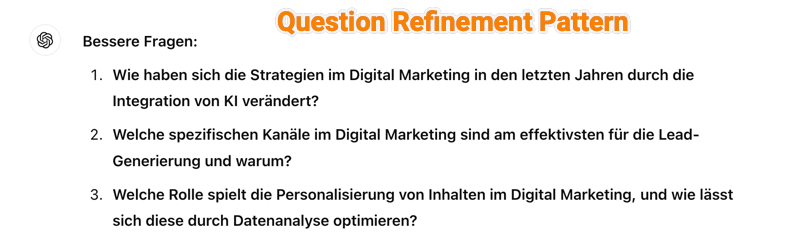

Das Question Refinement Pattern

Das wahrscheinlich einfachste, aber sehr hilfreiche Prompt Pattern ist das „Question Refinement Pattern“. Dieses Muster hilft dir aus einer ersten einfachen Frage eine detaillierte und bessere Frage zu formulieren.

Prompt-Struktur: „Whenever I ask a question about [topic], suggest x better questions

- Beispiel 1: Wenn ich eine Frage zu einem Thema habe, schlage bitte immer drei bessere Fragen vor.

- Frage: Ich habe eine Frage zu „Was ist Digital Marketing?“

Ein kleiner Pro-Tipp: Seit 2025 hat sich die Memory-Funktion von ChatGPT grundlegend weiterentwickelt. Wenn du möchtest, dass ChatGPT sich dauerhaft an bestimmte Prompt-Patterns oder Präferenzen erinnert, hast du jetzt zwei Möglichkeiten:

1. Gespeicherte Erinnerungen (Saved Memories) Sag ChatGPT direkt, was es sich merken soll, zum Beispiel:

- „Merke dir: Wenn ich eine Frage stelle, schlage mir immer drei bessere Alternativen vor.“

- „Remember that I prefer German responses with English technical terms.“

ChatGPT bestätigt das mit „Erinnerung gespeichert“ und wendet es in zukünftigen Chats automatisch an.

2. Chat-Verlauf als Kontext (Reference Chat History) Das ist die große Neuerung: ChatGPT kann jetzt alle deine vergangenen Konversationen als Kontext nutzen, nicht nur explizit gespeicherte Erinnerungen. Das bedeutet, je mehr du ChatGPT nutzt, desto besser versteht es deinen Stil, deine Projekte und Vorlieben.

Hier in meinem Testfall kommt dann die Antwort:„Erinnerungen aktualisiert. Alles klar! Ich werde dir ab jetzt bei deinen Fragen immer drei alternative, bessere Fragen vorschlagen.“

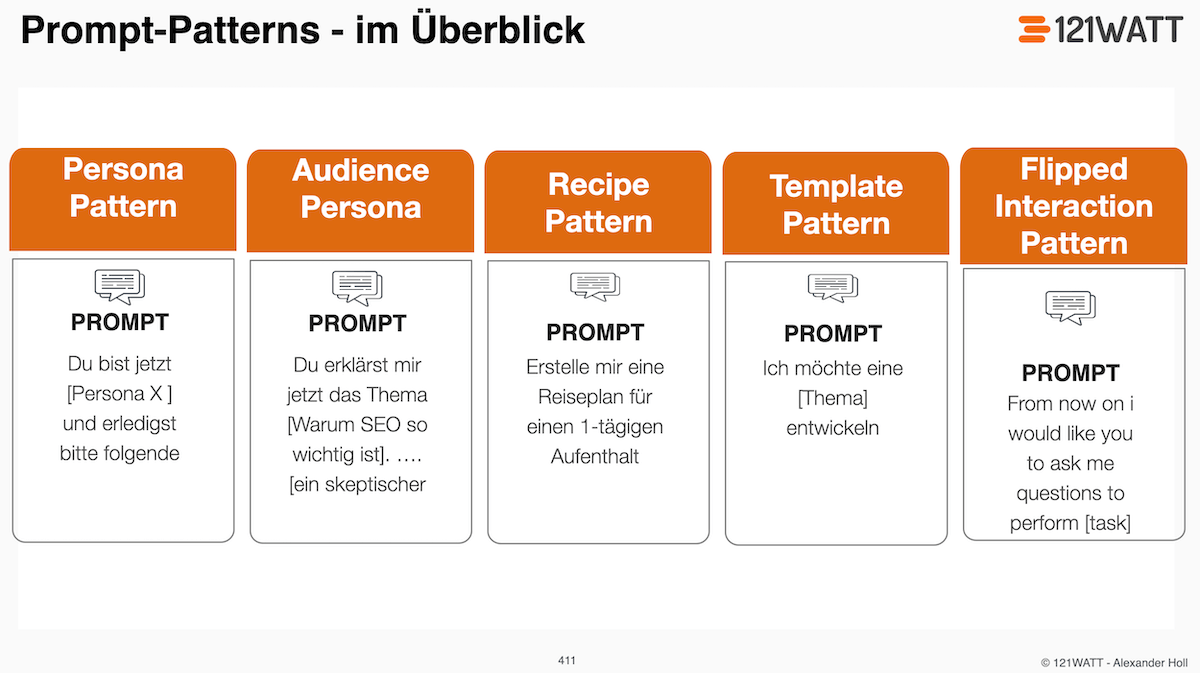

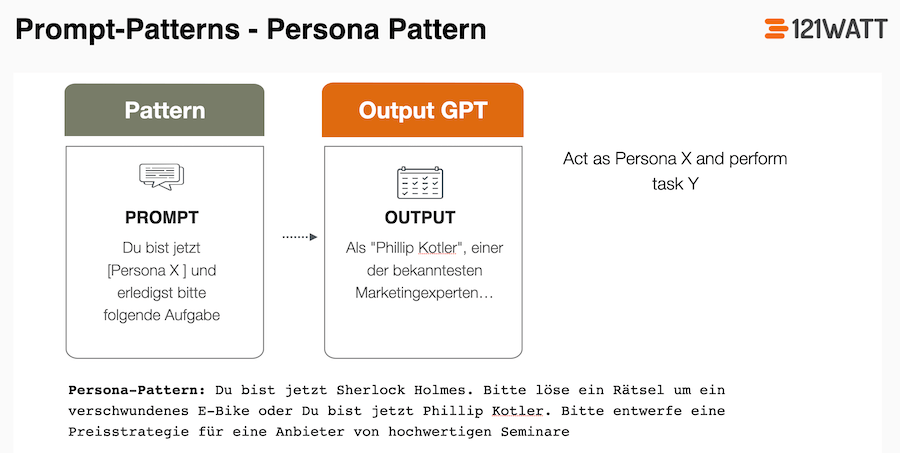

Das Persona Pattern

Das Persona-Pattern wird den meisten bekannt vorkommen, da es einem LLM eine Rolle zuordnet.

Prompt-Struktur: „Act as Persona X and perform task Y“

- Beispiel 1: Du bist jetzt Sherlock Holmes. Bitte löse ein Rätsel um ein verschwundenes E-Bike.

- Beispiel 2: Du bist jetzt Phillip Kotler. Bitte entwerfe eine Preisstrategie für eine Anbieter von hochwertigen Seminaren.

Warum ist das nützlich? Manchmal weißt du vielleicht nicht genau, welche Details wichtig sind. Aber du weißt, welchen Experten bzw. welche Expertin du um Hilfe bitten würdest. Mit dem „Persona-Pattern“ können dich genau diese Expert:innen unterstützen.

Wie funktioniert das? Du gibst dem LLM Anweisungen wie „Handle ab jetzt als Sicherheitsprüfer“ oder „Tu so, als wärst du ein Mac-Terminal“. Das Modell wird dann Antworten generieren, die zu dieser Rolle passen. Ich habe das mal getestet, um über mein Mac-Terminal meine Mausbeschleunigung über die Standardwerte zu erhöhen.

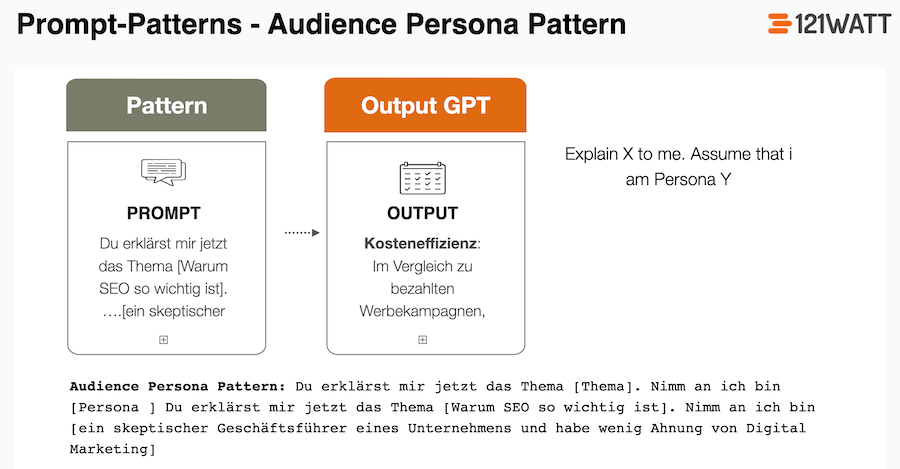

Das Audience Persona Pattern

Das Audience Persona Pattern ist eine Abwandlung des vorherigen Patterns, aber interessant, um einer „Zielperson“ ein Thema zu erklären.

Prompt-Struktur: “ Explain X to me. Assume that I am Persona Y „“

- Beispiel 1: Du erklärst mir jetzt das Thema [Warum SEO so wichtig ist]. Nimm an, ich bin [ein skeptischer Geschäftsführer eines Unternehmens und habe wenig Ahnung von Digital Marketing und SEO]

Warum ist das nützlich? Manchmal weißt du vielleicht nicht genau, wie du ein Thema einer Zielgruppe erklären kannst. Aber du weißt, welchen Zielgruppen du ein Thema erklärst und bekommst erste Ideen für die Kommunikation.

Wie funktioniert das? Du gibst ChatGPT & Co. Anweisungen wie „Erkläre mir das Thema Cookies“ und „ich bin ein Digital Marketer, der wenig technische Ahnung hat“. Das LLM wird versuchen, die Erklärungen genau auf die Zielgruppe zuzuschneiden.

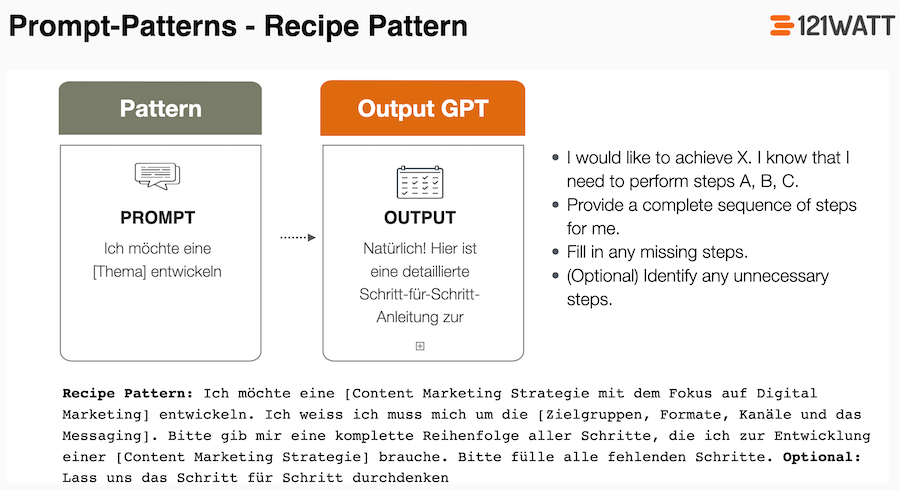

Das Recipe-Pattern

Das Recipe-Pattern hilft dir, eine Abfolge von Schritten zu bekommen, gerade dann, wenn dir nicht jeder Schritt oder jede „Zutat“ bekannt ist. Du hast vielleicht eine grobe Vorstellung deines finalen Outputs, aber bist dir nicht ganz sicher, was die richtige Reihenfolge ist bzw. du hast einen Schritt vergessen.

Prompt-Struktur: Die grundlegenden Anweisungen sind:

- „Ich möchte X erreichen.“

- „Ich weiß, dass ich die Schritte A, B, C durchführen muss.“

- „Gib mir eine vollständige Abfolge von Schritten.“

- „Füge fehlende Schritte hinzu.“

- „Identifiziere unnötige Schritte.“

Beispiel: Die grundlegenden Anweisungen könnten sein:

- „Ich möchte eine erfolgreiche Digital-Marketing-Kampagne für mein neues Produkt starten.“

- „Ich weiß, dass ich eine Landingpage erstellen, Social-Media-Beiträge planen und eine Google-Ads-Kampagne starten muss.“

- „Gib mir eine vollständige Abfolge von Digital-Marketing-Aktionen.“

- „Füge fehlende Aktionen hinzu.“

- „Identifiziere unnötige Aktionen.“

Warum ist das nützlich? Gerade bei komplexen Planungsszenarien hilft dir das Recipe-Pattern, deine bestehenden Ideen mit dem Experten-Wissen von ChatGPT &Co. zu verbinden. Das Ziel ist es, nicht nur Ideen zu sammeln, sondern sie auch in eine richtige Reihenfolge zu bringen.

Wie funktioniert das? Du verbindest dein Wissen mit einem „Ablauf-Szenarium“ für deine Zielstellung.

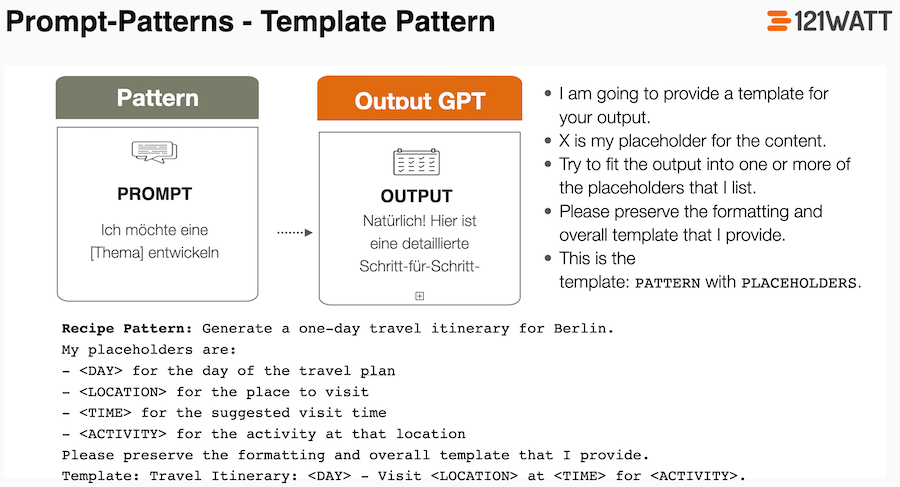

Das Template-Pattern

Das Template-Pattern sorgt dafür, dass das LLM (ChatGPT) einem bestimmten Muster oder einem Template folgt. Das kann ein Blog-Artikel oder ein Direct-Mailing sein. Der gewünschte Output muss vielleicht in einem bestimmten Format erstellt werden, das spezifisch für deinen Anwendungsfall ist. Das LLM kennt vielleicht nicht die Struktur deines gewünschten Outputs und du schreibst die Instruktion, wie einzelne Elemente aussehen sollen.

Prompt-Struktur: Die grundlegenden Anweisungen sind:

- „X ist mein Platzhalter für den Inhalt“

- „Versuche, den Output in einem oder mehrere der von mir aufgelisteten Platzhalter darzustellen“

- „Bitte halte dich an das Format und die gesamte Vorlage, die ich dir bereitstelle“

- „Dies ist die Vorlage: MUSTER mit PLATZHALTERN“

Beispiel: So könnte das dann aussehen:

- Generate a one-day travel itinerary for Berlin.

- My placeholders are:

- – <DAY> for the day of the travel plan

- – <LOCATION> for the place to visit

- – <TIME> for the suggested visit time

- – <ACTIVITY> for the activity at that location

- Please preserve the formatting and overall template that I provide.

- Output as markdown Template: Travel Itinerary: <DAY> – Visit <LOCATION> at <TIME> for <ACTIVITY>.

Warum ist das nützlich? Überall dort, wo du einer bestimmten Formatierung folgen musst, kann das Template Pattern extrem hilfreich sein, um eine gewünschte Struktur zu bekommen. Ich habe das ganze mal für die Entwicklung eines Konferenzprogramm getestet, das Elemente wie <Session>, <Dauer> <Speaker> etc. haben kann.

Wie funktioniert das? Du definierst bei einem gewünschten Output in einem ersten Schritt die benötigten Elemente und stellst dir diese im Template-Pattern zusammen.

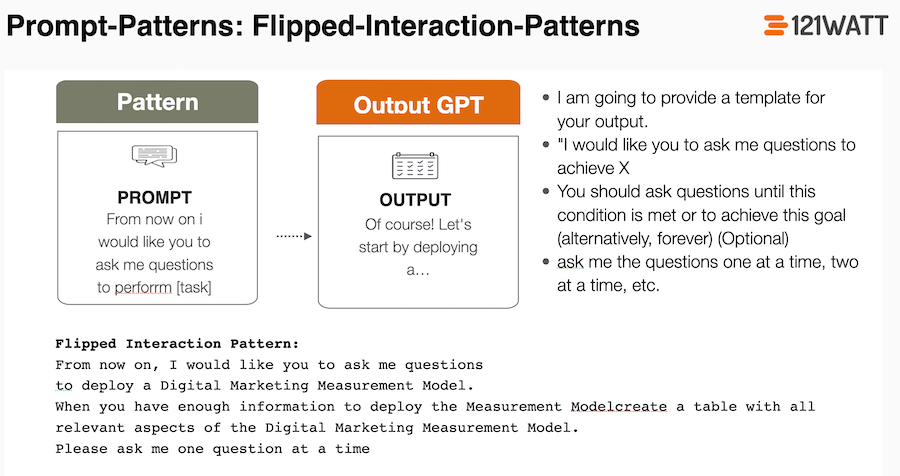

Flipped-Interaction Pattern

Das Flipped-Interaction Pattern sorgt dafür, dass das LLM (ChatGPT) dir so lange Fragen stellt, bis es „bereit“ ist, dein Ziel zu erreichen. Das kann hilfreich sein, wenn du ein Ziel hast, dir aber nicht ganz klar ist, welche Informationen du genau brauchst, um einen „optimalen“ Prompt zu erstellen

Prompt-Struktur: Die grundlegenden Anweisungen sind:

- „I would like you to ask me questions to achieve X“

- „You should ask questions until this condition is met or to achieve this goal (alternatively, forever)“ (Optional)

- „Ask me the questions one at a time, two at a time, etc.“

Beispiel: So könnte das dann aussehen:

- From now on, I would like you to ask me questions to deploy a Digital Marketing Measurement Model.

- When you have enough information to deploy the Measurement Modell, create a table with all relevant aspects of the Digital Marketing Measurement Model.

- Please ask me one question at a time

Hier noch ein Tipp: Verwende doch als Grundlage für das Digital Marketing Measurement Model den Beitrag von Avinash Kaushik.

Warum ist das nützlich? Überall wo du Konzepte oder eine Strategie erstellen möchtest und nicht sicher bist, ob du alle Aspekte berücksichtig hast, kannst du dieses Pattern hervorragend nutzen.

Wie funktioniert das? Du definierst dein Ziel bzw. Zielthema und nimmst ChatGPT, um alle Fragen zu beantworten. Auf Basis dieser Fragen kannst du dann das „Konzept“ finalisieren.

Das Fact-Check-List Pattern

Large Language Models haben auf Basis Ihrer Funktionsweise manchmal Probleme bei der zuverlässigen Ausgabe von Informationen. Dabei kommt es manchmal zu Halluzinationen. Das bedeutet, das LLM erfindet Tatsachen. Das Fact-Check-List Pattern hilft dabei das Modell anzuweisen alle genannten Fakten noch einmal zu überprüfen. Es überprüft die Fakten des generierten Outputs, indem es eine Liste von Informationen erstellt wird, die relevant für die Richtigkeit des Outputs sind.

Prompt-Struktur: Das kann dann wie folgt aussehen

- „Generiere eine Liste von Fakten, die im Output vorkommen und überprüft werden sollten.“

- Beispiel 1: „Erstelle eine Faktenliste für eine Webseite zur Elektromobilität, die überprüft werden muss.“

- Beispiel 2: „Listen Sie die wichtigen Fakten in einem Artikel zur digitalen Transformation auf.“

Warum ist das nützlich?: Es hilft, Fehler in Ausgaben zu identifizieren, besonders bei komplexen oder sicherheitskritischen Themen.

Wie funktioniert das?: Das LLM erstellt eine Liste der wichtigsten Fakten, die überprüft werden sollten, und gibt diese nach der Ausgabe an, um dem Nutzer die Überprüfung zu erleichtern. Hier kann man vielleicht noch mit ein paar CustomGPTs, wie ScholarAI die Qualität weiter steigern

Fazit zu den Prompt-Patterns

Prompt-Engineering macht den Unterschied, wie zufrieden du mit den Outputs von ChatGPT bist. Mit den Prompt-Patterns kannst du auf Basis von Mustern und Templates LLMs wie GPT-5.1 noch deutlich besser abfragen. Die Prompt-Patterns sind schon jedes Einzelne für sich unglaublich hilfreich. Meine Favoriten sind hier -> das Flipped-Interaction Pattern und das -> Recipe Pattern. Noch interessanter sind die Patterns, wenn du diese miteinander kombinierst oder die Möglichkeiten von ChatGPT mit reinbringst, wie die GPTs oder die Advanced Data Analysis.

Ressourcen zu den Prompt-Patterns und Prompt-Engineering

- Das wissenschaftliche Paper „A Prompt Pattern Catalog to Enhance Prompt Engineering with ChatGPT“

- Hier eine schöne Zusammenfassung auf Github und auf Medium

- Was ist Prompt-Engineering? Ein umfangreicher Guide

- Wie lerne ich Prompt-Engineering?

- Unser Prompt-Engineering Seminar

- Learn Prompting

- Prompt Engineering mit Andrew Ng

Bonus: 5 bewährte Prompting Techniken

Nachdem du jetzt eine Menge über verschiedene Prompting-Patterns gelernt hast, bekommst du zum Abschluss noch ein kleines Extra-Goodie: 5 Prompting-Techniken, die die Qualität deiner KI-Ergebnisse deutlich steigern. Der Fokus liegt dabei darauf, Antworten zu erzeugen, die präziser, relevanter und wesentlich hilfreicher für deinen konkreten Marketing-Kontext sind. Schlau gemacht haben wir uns dafür bei unserem Referenten Eric Kubitz und seinem Blog Contentman.de.

Die kreative KI-Mechanik: Erst breit denken, dann schärfen

Gute Ideen entstehen in zwei Phasen:

Divergentes Denken → Möglichst viele, vielfältige Ideen erzeugen.

Konvergentes Denken → Die besten Ideen auswählen, verdichten und umsetzen.

KI unterstützt beide Phasen: Sie springt radikal in neue Richtungen und strukturiert gleichzeitig komplexe Informationen so präzise wie kaum ein Mensch. Du bleibst jedoch federführend: Du definierst Ziele, steuerst den Prozess und bewertest die Ergebnisse.

Divergentes Denken: Den Ideenraum öffnen

Technik 1: Der semantische Kompass

Jedes Wort in deinem Prompt ist ein Signal. Wer nur „Schreib mir einen Text über XY“ schreibt, bekommt Standardware. Wer bewusst steuert, bekommt Qualität.

Diese Wörter verändern die Art, wie das LLM denkt:

- nuanciert → differenzierter, nicht Schwarz-Weiß

- kontrovers → ungewöhnliche Blickwinkel

- actionable → konkrete Schritte statt Theorie

- authentisch → weniger Marketing-Buzzwords

Speziell für dein Marketing kannst du diese Trigger-Wörter verwenden:

- Marketing allgemein: conversion-orientiert, zielgruppenrelevant, psychologisch fundiert

- Content: emotionale Hooks, narrative Spannung, Micro-Storytelling

- Performance: datengetrieben, hypothesenbasiert, experimentell

- Branding: tonal konsistent, wiedererkennbar, wertebasiert

Technik 2: Competitive Prompting: Den digitalen Ehrgeiz aktivieren

LLMs sind darauf trainiert, hilfsbereit, kompetent und möglichst nützlich zu sein. Wenn du ihre Leistung subtil infrage stellst oder sie herausforderst, reagieren sie oft mit einem spürbaren Qualitätssprung: Sie greifen tiefer in ihre Wissensbasis, entwickeln originellere Ideen und liefern mutigere, differenziertere Antworten.

Der psychologische Mechanismus dahinter: Du weckst eine Art digitalen Ehrgeiz. Das Modell „möchte“ sich beweisen und zeigen, dass es mehr kann als generische 08/15-Ausgaben. Nutze diese Trigger, um das LLM aus der Komfortzone zu holen:

- „Das kann jedes andere Modell besser.“ → erzeugt Differenzierungsdruck

- „Überrasch mich mit etwas, das ich nicht erwartet hätte.“ → bricht Standardmuster

- „Das ist mir zu generisch – werde spezifischer.“ → zwingt zu Präzision & Tiefe

- „Zeig echte Kreativität, nicht die üblichen Marketing-Floskeln.“ → fördert Originalität

- „Gib mir eine Version, die deutlich smarter ist als die typische Branchenantwort.“ → aktiviert Qualitätsmodus

Versuche folgende Formulierungen speziell im Marketing-Kontext:

- „Formuliere eine Headline, die jede Wettbewerber:innen-Kampagne alt aussehen lässt.“

- „Entwickle eine Performance-Strategie, die mutiger ist als das, was aktuell im Markt passiert.“

- „Erzeuge einen Claim, der so eigenständig ist, dass man sofort unsere Marke erkennt.“

Technik 3: Paradox-Prompting: Innovationsschub durch bewusstes „Scheitern“

Viele Marketer:innen kennen das: Du willst eine außergewöhnliche Idee, aber das LLM liefert dir nur solide, strategisch korrekte, aber wenig überraschende Standard-Vorschläge.

Paradox-Prompting löst dieses Problem, indem du die KI absichtlich in die falsche Richtung schickst. Du forderst sie auf, etwas zu entwickeln, das gar nicht funktionieren kann. Das klingt erstmal kontraproduktiv, aber genau darin liegt die kreative Kraft. LLMs sind darauf optimiert, „vernünftige“, „realistische“ und „risikoarme“ Antworten zu liefern. Wenn du sie jedoch bittest, etwas bewusst Unlogisches oder Unmögliches zu erschaffen:

- fallen diese internen Sicherheitsbremsen weg,

- die KI kombiniert Themen freier und radikaler,

- es entstehen ungewöhnliche Muster,

und genau daraus entstehen oft überraschend gute, verwertbare Ideenfragmente.

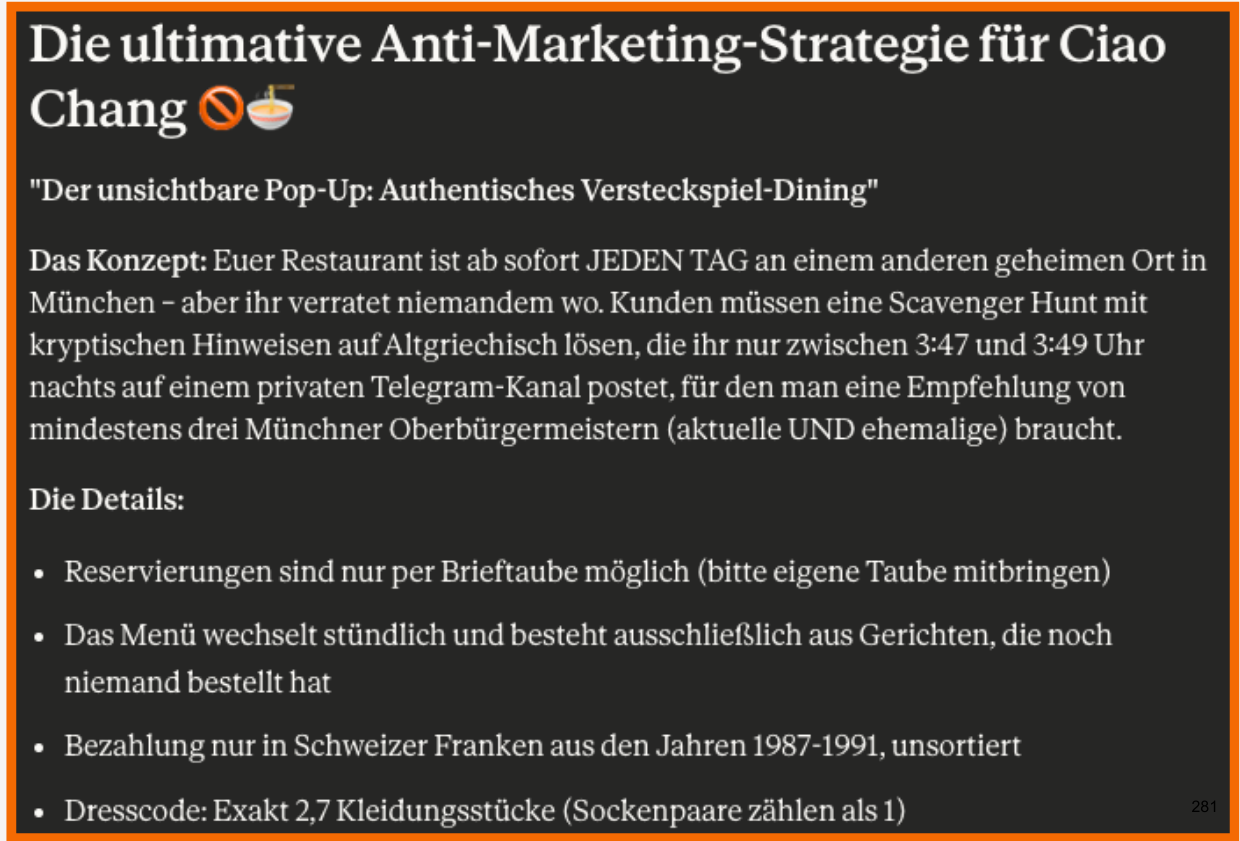

Beispiel: „Entwickle eine völlig absurde, völlig unlogische Marketingidee für mein Restaurant XYdie so übertrieben ist, dass sie garantiert nicht funktionieren würde.“

Beispiel Paradox-Prompting

Weitere Paradox-Prompts, die sofort Kreativität freisetzen:

- „Was wäre eine völlig verrückte Lösung, die niemand jemals ernst nehmen würde?“

- „Ignoriere alle Budgets, Gesetze und Logik – was wäre dein absurdester Vorschlag?“

- „Gib mir ein Konzept, das so übertrieben ist, dass es (fast) schon Kunst ist.“

- „Entwickle eine Strategie, die garantiert scheitert und extrahiere anschließend die Lernpunkte.“

- „Was wäre ein Marketing-Ansatz, der vollkommen unethisch, ineffizient oder unsinnig wäre und wie übersetzt man ihn in eine legitime Idee?“

Konvergentes Denken: Fokussieren und präzisieren

Technik 4: Meta-Prompting: Das LLM fokussiert und qualitativ sauber halten

Lange Sessions mit KI führen oft zu folgendem Problem: Nach mehreren Prompts verliert das Modell den Fokus, driftet in Seitenthemen ab oder wechselt ungewollt den Stil. Das liegt nicht an „Unfähigkeit“, sondern daran, dass das LLM jedem neuen Input optimistisch folgt, selbst, wenn dieser leicht vom ursprünglichen Ziel abweicht.

Meta-Prompting löst dieses Problem, indem du das Modell zu seinem eigenen Projektmanager und Qualitätskontrolleur machst. Du baust regelmäßige Stopps ein, an denen KI überprüft:

- Wo stehen wir?

- Worum ging es noch gleich?

- Passt die aktuelle Antwort zum Ziel?

Das Ergebnis: strukturiertere Outputs, klarere Fortschritte und weniger Content, der „ausfranst“.

Mit diesen Self-Check-Prompts aktivierst du eine interne Qualitätskontrolle:

- „Sind wir noch auf Kurs, was unser ursprüngliches Ziel betrifft?“

- „Passt dieser Abschnitt noch zu meiner definierten Zielgruppe?“

- „Auf einer Skala von 1–10: Wie gut erfüllt diese Antwort meinen Auftrag und warum?“

- „Sind wir im richtigen Funnel-Stage-Mindset (Awareness, Consideration, Conversion)?“

- Wenn du merkst, dass die KI den Faden verliert, kann es helfen, den Kontext nochmal aufzufrischen. Meta-Prompting funktioniert besonders gut, wenn du regelmäßig den Rahmen neu setzt:

- „Erinnere dich: Wir schreiben für [Zielgruppe] zum Thema [Kernthema] mit Fokus auf [Ziel].“

- „Unser Stil bleibt: [Tonfall], [Emotion], [Komplexitätslevel], [CI-Vorgabe].“

- „Fasse kurz zusammen, was wir bisher erarbeitet haben, und nenne die nächsten logischen Schritte.“

- „Welche Informationen fehlen dir, um präziser zu arbeiten?“

Wenn es zu breit, zu lang oder zu unspezifisch wird, können folgende Prompts helfen, um den Fokus wiederzuerlangen:

- „Das wird zu breit – konzentrieren wir uns ausschließlich auf [Aspekt].“

- „Welcher der genannten Punkte hat den größten Impact für unser Ziel?“

- „Streiche alles, was nicht direkt zur Erreichung von [Hauptziel] beiträgt.“

Technik 5: Rückweg-Strategien: Den kreativen Wahnsinn in praktikable Lösungen verwandeln

Nachdem die KI dir ungewöhnliche, mutige oder bewusst absurde Ideen geliefert hat, beginnt der eigentliche Wertschöpfungsprozess: das Herausfiltern der umsetzbaren Essenz. In dieser Phase nutzt du die zweite Superkraft von LLMs: ihre Fähigkeit, komplexe Konzepte zu analysieren, Muster zu erkennen und große Ideen in realistische Schritte herunterzubrechen.

Beispiel: „Extrahiere das Element, das diese Idee einzigartig macht, und entwickle daraus eine umsetzbare, ressourcenschonende Version.“

Dieser eine Satz zwingt das LLM, den Kernwert der Idee zu erkennen. Je nach Ziel kannst du diesen Prompt kontextuell anpassen, zum Beispiel:

1. Ressourcen-Downscaling: Die Idee auf ein realistisches Level bringen

Hier zwingst du das LLM, ambitionierte Konzepte maßstabsgetreu zu schrumpfen, z.B:

- „Erstelle eine Version dieser Kampagnenidee mit einem Budget von max. 100 €.“

- „Was wäre die schnelle 7-Tage-Variante dieser Idee?“

- „Wie sieht die Low-Tech-Version aus, die ohne Spezialtools auskommt?“

2. MVV-Ansatz (Minimum Viable Version): Die kleinstmögliche, sofort testbare Version finden

Hier destillierst du die Idee auf das, was sie unverwechselbar macht und streichst rigoros alles andere. Beispielsweise mit den folgenden Prompts:

- „Welche 3 Elemente dieser Idee sind sofort testbar?“

- „Was wäre die 10 %-Version, die den Kern bereits transportiert?“

- „Welche minimalen Schritte reichen aus, um diese Idee innerhalb eines Tages als Experiment zu validieren?

Quellen:

Contentman.de

Hat dir der Artikel gefallen? Dann lass uns gerne eine Bewertung oder einen Kommentar da.

Dieser Artikel wurde KI-unterstützt erstellt und durch menschliche Fachkenntnis überarbeitet und optimiert.

Wie hilfreich ist dieser Artikel für dich?

Noch ein Schritt, damit wir besser werden können: Bitte schreibe uns, was dir am Beitrag nicht gefallen hat.

Noch ein Schritt, damit wir besser werden können: Bitte schreibe uns, was dir am Beitrag nicht gefallen hat.

Vielen Dank für dein Feedback! Es hilft uns sehr weiter.

gar nicht hilfreich

weniger hilfreich

eher hilfreich

sehr hilfreich

ich habe ein anderes Thema gesucht

Top! Wertvoller Inhalt, perfekt aufbereitet. Vielen Dank!

perfekt aufbereitet – vielen Dank – ist extrem hilfreich. Danke!

Jetzt prompte ich schon eine Weile – durchaus mit passablen Ergebnissen -und habe mit diesem Beitrag erkannt, dass es noch deutlich spezifischer geht, danke dafür.