Was du über URL-Parameter wissen musst: von UTM bis Duplicate Content

Keine Artikel mehr verpassen? Jetzt Newsletter abonnieren »

Level: Beginner

URL-Parameter wirken auf den ersten Blick unscheinbar, ein paar kryptische Zeichen hinter dem Fragezeichen. Doch sie haben es in sich: Sie steuern Tracking, personalisieren Inhalte oder beeinflussen sogar die Indexierung durch Suchmaschinen. Genau deshalb solltest du wissen, wie du sinnvoll mit ihnen umgehst und wo sie Probleme verursachen können. In diesem Artikel schauen wir uns an, welche Arten von URL-Parametern es gibt, wie du sie für Kampagnen und Analysen nutzt und was du dabei aus SEO-Sicht unbedingt beachten solltest. Denn falsch eingesetzt, können sie Duplicate Content erzeugen, deine Crawl-Budget-Effizienz verschlechtern oder Tracking-Daten verzerren. Zeit, Ordnung in die Parameter-Chaos zu bringen, mit klaren Empfehlungen und einem Blick auf Tools wie die Google Search Console und UTM-Parameter im Kampagnentracking.

Was sind URL-Parameter und warum sind sie wichtig?

URL-Parameter sind Zusatzinformationen, die an eine URL angehängt werden, um bestimmte Funktionen oder Inhalte zu steuern. Sie beginnen immer mit einem Fragezeichen (?) und bestehen aus einem Schlüssel-Wert-Paar wie z. B. ?utm_source=newsletter oder ?sort=preis_aufsteigend. Mehrere Parameter können mit einem kaufmännischen Und-Zeichen (&) verknüpft werden.

In der Praxis erfüllen Parameter viele Zwecke: Sie helfen beim Kampagnen-Tracking, filtern Produktlisten, speichern Sitzungsdaten oder personalisieren Inhalte. Genau darin liegt auch ihr Potenzial und ihr Risiko. Denn wenn Parameter falsch eingesetzt werden, kann das zu gravierenden Problemen führen: Duplicate Content, ineffizientes Crawling, verzerrte Tracking-Daten oder gar Indexierungsfehler.

Deshalb ist es wichtig, URL-Parameter nicht als nebensächliches Technikdetail zu sehen, sondern als aktiven Bestandteil deiner SEO- und Tracking-Strategie. Wer ihre Funktionsweise versteht und klare Regeln im Umgang damit hat, schützt langfristig die Sichtbarkeit der eigenen Website und sorgt für saubere Daten.

Arten von URL-Parametern

Nicht alle URL-Parameter funktionieren gleich und nicht alle haben Auswirkungen auf den Seiteninhalt. Grundsätzlich lassen sich Parameter in zwei Kategorien einteilen: aktive und passive Parameter.

Aktive Parameter

Aktive Parameter verändern den dargestellten Inhalt der Seite. Dazu gehören zum Beispiel:

?sort=preis_aufsteigend: sortiert eine Produktliste nach Preis?filter=fahrrad: zeigt nur Produkte mit dem Schlagwort „Fahrrad“?page=2: ruft eine bestimmte Paginierung auf

Diese Parameter sind funktional notwendig, aber aus SEO-Sicht kritisch, weil jede Variante technisch gesehen eine eigene URL darstellt. Wird hier keine klare Struktur eingehalten, können schnell Dutzende Varianten entstehen, die Suchmaschinen crawlen und indexieren.

Passive Parameter

Passive Parameter hingegen verändern den Seiteninhalt nicht. Sie dienen rein der Analyse und dem Tracking:

?utm_source=newsletter&utm_medium=email?gclid=123xyz(automatisch von Google Ads erzeugt)

Obwohl passive Parameter keine inhaltlichen Änderungen hervorrufen, können auch sie aus SEO-Sicht problematisch sein, wenn Suchmaschinen sie indexieren. Denn auch diese URLs gelten als eigenständige Varianten, was zu Duplicate Content führen kann.

Beispiel: Eine URL mit mehreren Parametern

https://www.beispielshop.de/fahrradhelme?utm_source=newsletter&utm_medium=email&sort=preis_absteigend&page=2

Was passiert hier?

- utm_source=newsletter und utm_medium=email

→ Passive Parameter, die dem Webanalyse-Tool zeigen, dass der Besuch aus dem E-Mail-Newsletter stammt. Sie verändern den Seiteninhalt nicht, dienen rein dem Tracking. - sort=preis_absteigend und page=2

→ Aktive Parameter, die die Darstellung der Seite beeinflussen: Produkte werden nach Preis sortiert, Seite 2 der Liste wird geladen. Diese Parameter erzeugen neue URL-Varianten, die SEO-Risiken wie Duplicate Content oder ineffizientes Crawling verursachen können, wenn sie nicht korrekt gesteuert werden.

Für Nutzer:innen ist das logisch. Für Suchmaschinen entstehen daraus jedoch vier kombinierte URL-Varianten und potenziell identische Inhalte. Genau hier beginnt das SEO-Problem, wenn keine Steuerung durch Canonicals oder Excludes vorhanden ist.

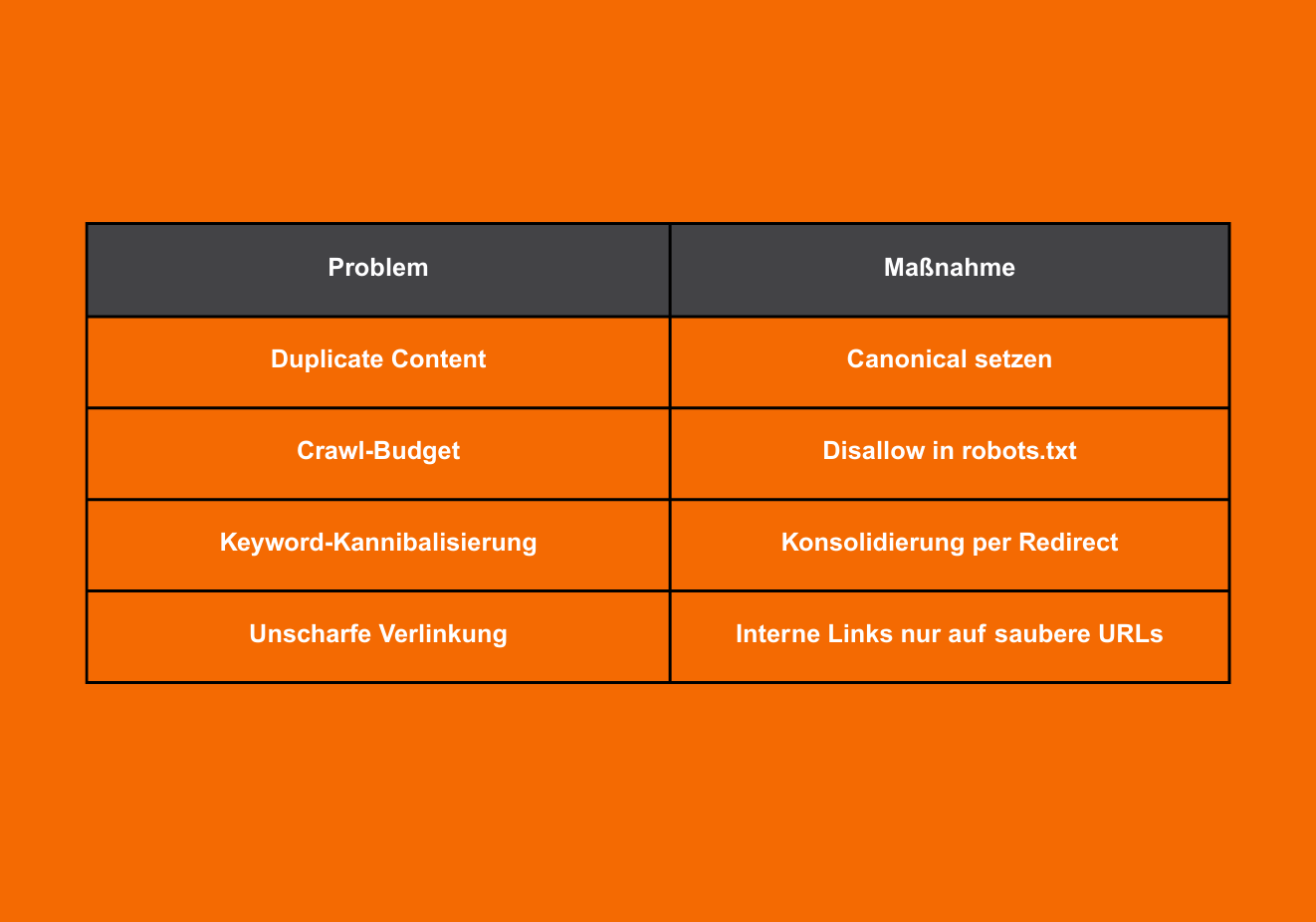

SEO-Risiken durch URL-Parameter

URL-Parameter zählen zu den häufigsten Ursachen für SEO-Probleme, vor allem, wenn sie ohne saubere Struktur eingesetzt werden. Der Grund: Suchmaschinen interpretieren jede URL-Variante technisch als eigene Seite. Und das kann weitreichende Folgen haben.

1. Duplicate Content

Wenn ein und derselbe Inhalt über verschiedene URLs mit unterschiedlichen Parametern erreichbar ist, entsteht Duplicate Content. Das betrifft vor allem Produktseiten, Blogartikel oder Kategorieseiten, die mit Sortierungen, Filtern oder Tracking-Parametern kombiniert werden. Google muss dann entscheiden, welche Variante indexiert werden soll, oft ohne klare Signale. Die Folge: falsche Seiten ranken oder wichtige Inhalte fliegen ganz aus dem Index.

Lösung:

- Verwende Canonical-Tags, um Suchmaschinen die bevorzugte URL-Variante mitzuteilen.

- Setze Parameter, die keine inhaltliche Änderung verursachen, in den Canonical-Versionen konsequent ab.

- Prüfe regelmäßig mit einem Crawler wie Screaming Frog, ob Canonicals korrekt implementiert sind.

2. Crawl-Budget wird verschwendet

Jede URL-Variante, die von Google gecrawlt wird, verbraucht Ressourcen. Bei großen Shops mit Tausenden von Produkten kann das bedeuten, dass Google sich durch unzählige unnötige URLs mit unterschiedlichen Parametern arbeitet und dabei die wirklich relevanten Seiten vernachlässigt. Das Crawl-Budget wird ineffizient genutzt.

Lösung:

- Setze gezielte Disallow-Regeln in der robots.txt, um bekannte Parameter (z. B. ?sort=, ?page=, ?filter=) vom Crawling auszuschließen.

- Nutze URL-Parameter-Filter in deinem Crawler-Setup, um das Ausmaß besser zu analysieren.

- Verwende Pagination-Tags (rel=next und rel=prev) bei Paginierungen, auch wenn Google sie aktuell nicht mehr als Rankingfaktor nutzt, helfen sie bei der Strukturierung.

3. Kannibalisierung von Rankings

Wenn ähnliche Inhalte über unterschiedliche URLs auffindbar sind, kann es zu interner Konkurrenz kommen. Mehrere Seiten ranken für dasselbe Keyword, aber keine davon besonders gut. Diese Keyword-Kannibalisierung schwächt die Sichtbarkeit und verwässert das Ranking-Potenzial.

Lösung:

- Führe regelmäßig eine Kannibalisierungsanalyse durch (z. B. mit der Search Console oder einem SEO-Tool wie SISTRIX).

- Leite irrelevante oder schwache Varianten per 301-Redirect auf die Hauptseite um, wenn eine Konsolidierung sinnvoll ist.

- Sorge für eine konsistente interne Verlinkung, die ausschließlich auf kanonische URLs verweist.

4. Unsaubere Linkstruktur

Interne Verlinkungen, die URL-Parameter enthalten, können die Seitenautorität aufsplitten. Wenn z. B. Newsletter-Links oder Filterkombinationen intern nicht korrekt gehandhabt werden, entstehen ungewollte Signale an Google, inklusive möglicher Indexierung unerwünschter Varianten.

Lösung:

- Achte darauf, dass interne Links nur auf saubere, parameterfreie URLs zeigen, besonders im Menü, in Footer-Bereichen oder bei Related Posts.

- Nutze Link-Cleaner-Tools in CMS-Systemen oder füge manuelle Regeln ein, um Tracking-Parameter beim internen Verlinken zu entfernen.

- Verwende Parameter nur für externe Kampagnen, nicht für interne Navigation.

Tracking und Kampagnensteuerung mit URL-Parametern

URL-Parameter sind ein zentrales Werkzeug im digitalen Marketing. Sie ermöglichen dir, gezielt nachzuvollziehen, über welchen Kanal Nutzer:innen auf deine Website gelangen und wie erfolgreich deine Kampagnen wirklich sind. Damit das Tracking funktioniert, kommt meist ein Standard-Set von Parametern zum Einsatz: die sogenannten UTM-Parameter.

UTM-Parameter gezielt einsetzen

UTM-Tags bestehen aus vordefinierten Parametern, die du an URLs anhängst. Sie liefern deinen Webanalyse-Tools wie Google Analytics oder Matomo wertvolle Kontextinformationen. Die wichtigsten Felder:

- utm_source: Kanal oder Plattform (z. B. newsletter, google, linkedin)

- utm_medium: Medium oder Kampagnenart (z. B. email, cpc, social)

- utm_campaign: konkrete Kampagne (z. B. fruehlingsaktion, blackfriday2026)

- Optional: utm_content (z. B. Anzeigenvariante) und utm_term (z. B. Keyword)

Beispiel:

https://www.beispielseite.de/landingpage?utm_source=linkedin&utm_medium=social&utm_campaign=whitepaper_download

Damit dein Tracking präzise bleibt, solltest du folgende Regeln beachten:

- Verwende UTM-Tags ausschließlich für externe Links

- Halte die Schreibweise konsistent (z. B. kein Mix aus „Email“ und „email“)

- Nutze ein zentrales Sheet zur Dokumentation und Namenskonvention

Tracking in Google Ads: ValueTrack und gclid

Neben UTM-Parametern kommen in Google Ads oft automatische Tracking-Parameter wie gclid (Google Click Identifier) oder benutzerdefinierte ValueTrack-Parameter zum Einsatz. Diese werden in der URL dynamisch ergänzt und sorgen für die Verbindung zwischen Klick und Conversion, zum Beispiel in Google Analytics oder im CRM.

Solche Tracking-Parameter müssen nicht manuell gesetzt werden, dürfen aber nicht indexiert werden. Sonst entstehen schnell hunderte URL-Varianten, die aus SEO-Sicht problematisch sind.

URL-Parameter effizient managen: Empfehlungen für SEO und Tracking

Ein strukturierter Umgang mit URL-Parametern spart dir nicht nur technische Probleme, sondern auch jede Menge Analysezeit. Die zentrale Frage lautet: Welche Parameter brauchst du wirklich und wie sorgst du dafür, dass sie keine Schäden anrichten?

1. Parameter gezielt einsetzen, nicht automatisch

Viele Systeme erzeugen Parameter automatisch: CMS, Filterfunktionen, Tracking-Tools oder Kampagnenmanager. Prüfe regelmäßig, welche Parameter tatsächlich benötigt werden. Alles, was keine inhaltliche Funktion erfüllt oder keine Analyse-Relevanz hat, sollte vermieden oder blockiert werden.

Tipp: Führe eine einfache Parameter-Inventur durch. Tools wie Screaming Frog oder Sitebulb helfen dir dabei, alle aktiven Parameter auf deiner Website sichtbar zu machen.

2. Canonical-Tags konsequent verwenden

Jede Seite mit Parameter-Varianten sollte ein eindeutiges Canonical-Tag enthalten, das auf die Hauptversion der URL verweist. So signalisierst du Suchmaschinen, welche Variante indexiert werden soll. Achte darauf, dass Parameter wie utm_ oder gclid nicht in der Canonical-URL enthalten sind.

3. Crawling gezielt steuern

Nicht jede URL muss gecrawlt werden. Um das Crawling effizient zu halten, kannst du bestimmte Parameter gezielt ausschließen:

- über robots.txt (z. B. Disallow: /*?sort=)

- über Meta Robots Tags (noindex, follow für irrelevante Filterseiten)

- durch interne Verlinkung: Nur auf „saubere“ URLs verlinken

Wichtig: robots.txt verhindert das Crawling, nicht das Indexieren, dafür ist ein zusätzliches noindex erforderlich.

4. Einheitliche Regeln im Team

Viele Probleme mit URL-Parametern entstehen, weil unterschiedliche Teams sie unterschiedlich verwenden. Deshalb lohnt sich ein gemeinsames Regelwerk:

- Einheitliche Benennungen und Schreibweisen

- Vorgaben, wo UTM-Parameter erlaubt sind (nur extern!)

- Klare Verantwortung: Wer erstellt, wer prüft, wer dokumentiert?

Eine einfache Excel-Vorlage mit allen aktiven Kampagnen und Parametern hilft schon, den Überblick zu behalten.

Best Practices und Fazit

URL-Parameter sind ein nützliches Werkzeug, aber nur dann, wenn du sie gezielt einsetzt und ihre technischen Auswirkungen verstehst. Egal ob im Tracking oder in der Filterlogik deines Shops: Jeder Parameter beeinflusst deine URL-Struktur, deine Datenqualität und im Zweifel auch deine Sichtbarkeit bei Google.

Die wichtigsten Best Practices im Überblick:

- Vermeide unnötige Parameter, vor allem solche, die automatisch durch Systeme erzeugt werden

- Nutze UTM-Parameter nur für externe Kampagnen, nicht für interne Links

- Setze Canonical-Tags konsequent ein, um die Haupt-URL zu definieren

- Sperre unwichtige Parameter per robots.txt oder steuere sie über noindex

- Verlinke intern nur auf saubere URLs, ohne Tracking-Parameter

- Dokumentiere alle aktive Parameter und Regeln im Team, um Wildwuchs zu vermeiden

Gerade bei Websites mit vielen dynamischen Seiten lohnt sich ein strukturierter Umgang mit URL-Parametern, nicht nur aus SEO-Sicht, sondern auch, um deine Trackingdaten zuverlässig auszuwerten.

Quellen: Semrush, SE Ranking, Google, Neil Patel

Hat dir der Artikel gefallen? Dann lass uns gerne eine Bewertung oder einen Kommentar da.

Dieser Artikel wurde KI-unterstützt erstellt und durch menschliche Fachkenntnis überarbeitet und optimiert.

Wie hilfreich ist dieser Artikel für dich?

Noch ein Schritt, damit wir besser werden können: Bitte schreibe uns, was dir am Beitrag nicht gefallen hat.

Noch ein Schritt, damit wir besser werden können: Bitte schreibe uns, was dir am Beitrag nicht gefallen hat.

Vielen Dank für dein Feedback! Es hilft uns sehr weiter.

gar nicht hilfreich

weniger hilfreich

eher hilfreich

sehr hilfreich

ich habe ein anderes Thema gesucht